「囚人のジレンマとDAG RWにおける真のジレンマ」

分析ゲーム理論に出てくる、囚人のジレンマの「理想解」は、2人とも黙秘するです。けれどリアルワールドでは、各人が自分にとって一番魅力的な選択肢を選んだ結果、協力した時よりも悪い結果を招いてしまうことが多くなります。

理由は単純で、当事者は俯瞰して利得表(ルールの全体像)を見られないからです。相手が黙秘する保証もない。自分が黙秘した結果だけが損になる恐怖が勝つ。結果として、裏切り(自白)に流れやすい。ここまでは教科書どおりです。

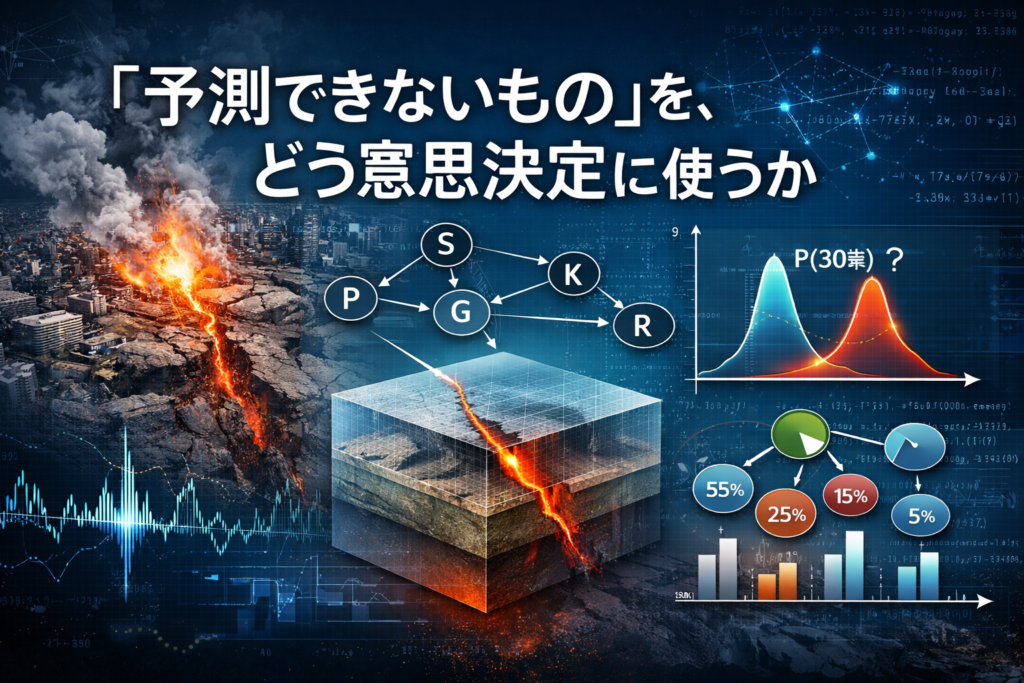

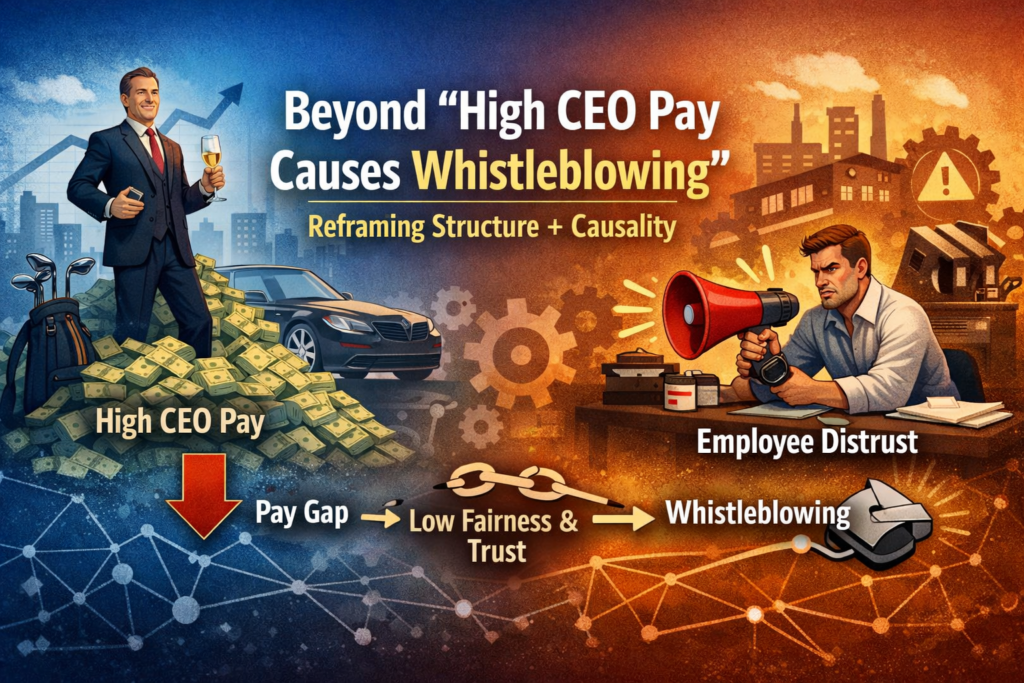

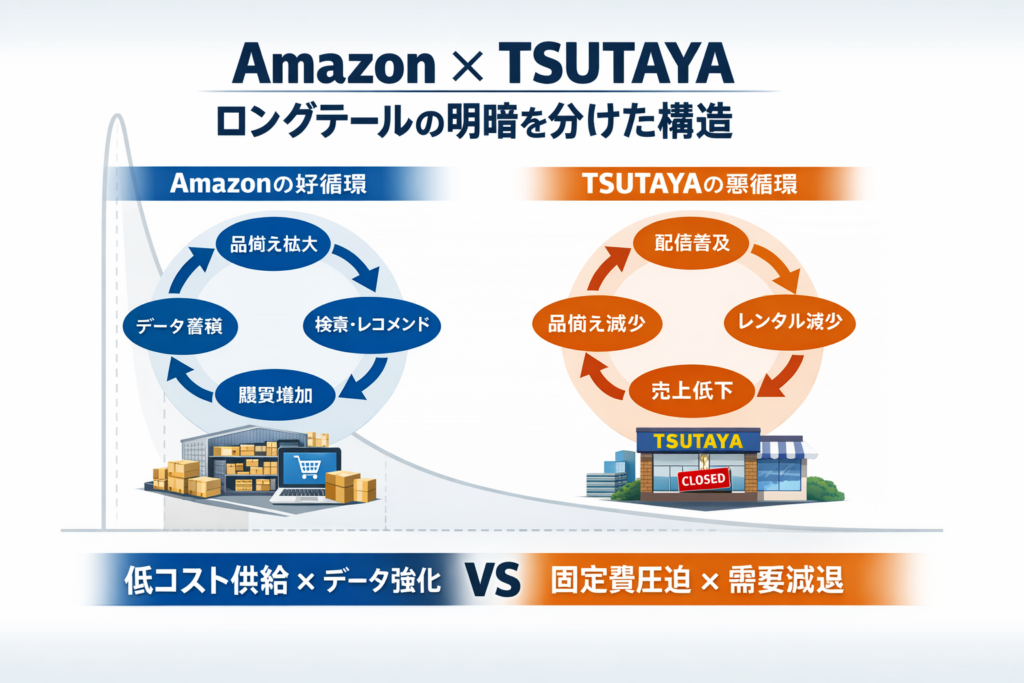

しかし、現実が難しいのはここからです。現実の「ジレンマ」は、利得表が固定されていません。上司の評価制度、監査の有無、罰の運用、情報の偏り、過去の人間関係、組織文化、そして“空気”までが、黙秘と自白の価値を日々書き換えています。つまり、私たちが対峙しているのは「利得表」ではなく、「利得表を生成する構造」です。

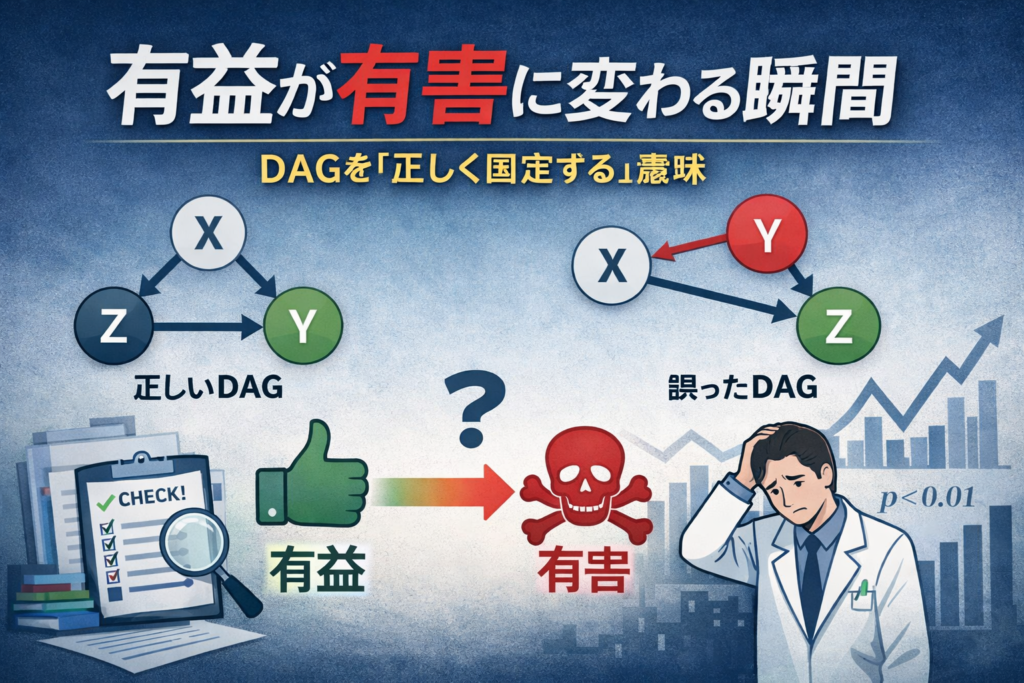

そこで効くのがDAG(因果グラフ)です。DAGは、当事者が見落としがちな“裏側の配線”を可視化します。たとえば「相手を信用できない」という心理は、単なる性格ではありません。過去の裏切り経験、評価制度、情報共有の欠如といった要因により生まれる“結果”かもしれない。ここを交絡として置けると、「裏切りが多い組織」と「裏切りが多い人」を混同せずに済みます。

さらにDAGは、媒介(メディエーター)を置けます。制度→不安→裏切り、のように、意思決定の途中にある心理や認知を変数として扱える。ビジネス現場で重要なのは、「裏切るな」と説教することではなく、「不安が裏切りを合理化する構造」を断つことです。たとえば監査の設計、反復取引の仕組み、情報の透明性、フェアな評価指標――こうした介入可能なノードが見えてきます。

そして一番の落とし穴が、固定(条件づけ)です。現場のデータは往々にして偏ります。クレームが出た案件だけ、退職者だけ、炎上したプロジェクトだけ。そこだけを見て「人が悪い」「現場が弱い」と結論づけると、選択バイアスで因果が逆転します。DAGは「どこに条件づけてしまったか」を明示できるので、“反省会をやった気になって終わる”を減らせます。

利得表を知っている観察者は「協力しろ」と言えます。でも当事者は、ルールが見えず、信頼も担保されず、罰の運用も不確実な中で意思決定しています。だから黙秘しない。裏切りはモラルの欠如というより、構造の帰結です。 ビジネスの本質も同じです。現場に「協力しろ」「顧客第一」「挑戦しろ」と言うだけでは変わりません。協力が合理的になる構造を設計しない限り、ジレンマは再生産され続けます。利得表を暗記するより、利得表を生む因果を描く。リアルワールドを知ることは、その構造を見抜くことです。