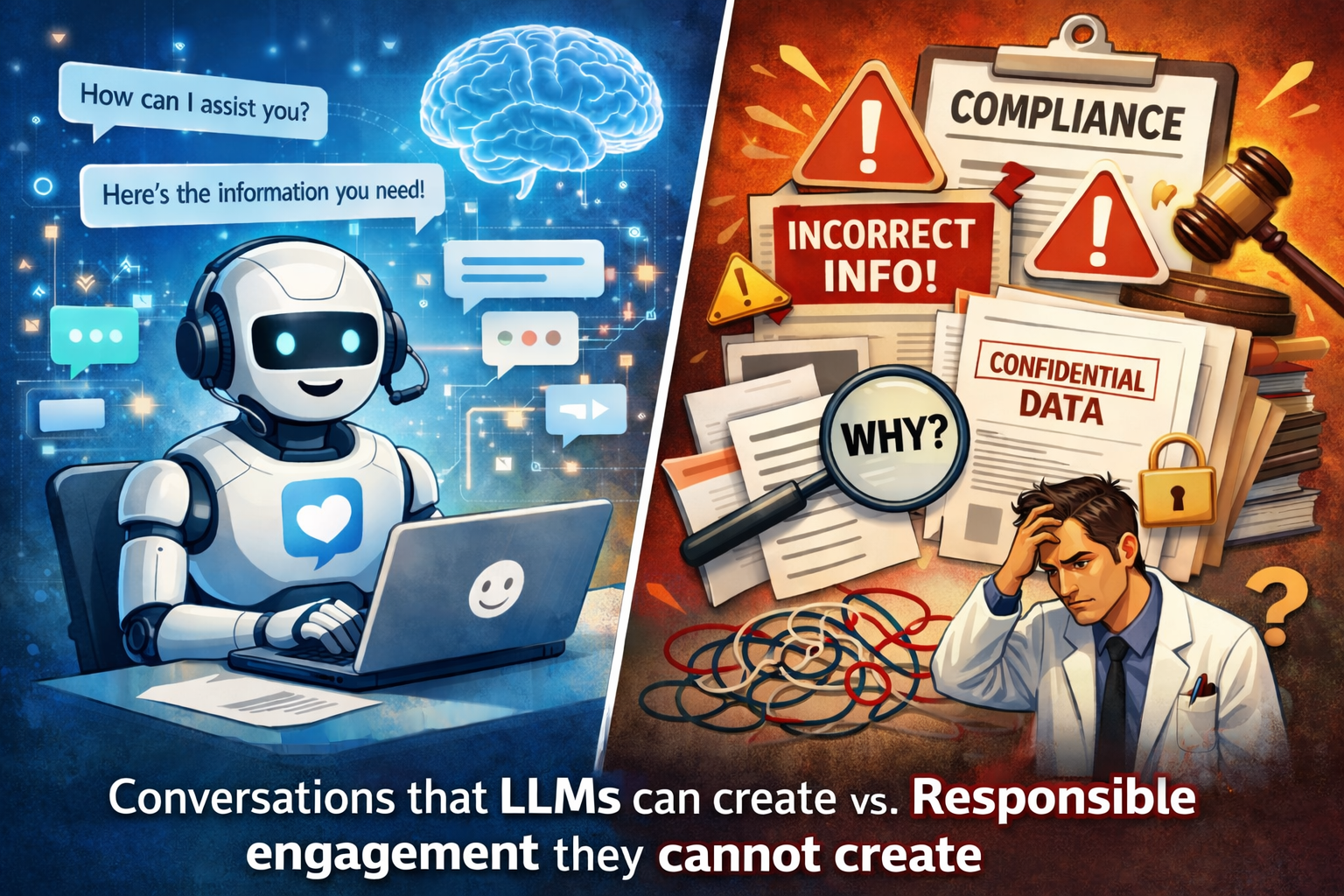

AI Agentがカスタマーエンゲージメントにも急速に広がっています。問い合わせ対応、情報提供、次のアクション提案まで、LLMが自然な文章で一気に肩代わりできる。これ自体は大きな進歩です。

しかし、製薬業では「LLM中心のアプローチ」をそのまま採用すると、ほぼ確実に直面する壁があります。それは、会話の品質ではなく、“責任の品質”です。

1. 「それっぽい正しさ」が最大のリスクになる

LLMは、誤りを「誤りとして」出しません。もっと厄介なのは、誤りを“もっともらしく”整えて出すことです。

一般業界なら「カスタマーサポートのミス」で済む場面でも、製薬では、誤情報がそのまま適正使用・安全性・信頼性に跳ね返ります。AIが一度でも添付文書やガイドラインに反した回答を出せば、炎上よりも先に、社内の品質・法務・安全性のアラームが鳴ります。結果として、現場のMRはAIを怖がり、活用は止まります。

2. 本質は「回答」ではなく「説明責任」にある

カスタマーエンゲージメントは、顧客の疑問に答えるだけでは成立しません。

製薬が扱うのは情報の“量”ではなく、“根拠と統制”です。つまり「なぜその回答なのか」「どの文書を参照したか」「誰がその表現を許可しているか」を後から説明できるかが価値になります。LLMの回答が良くても、監査で説明できないなら、運用は継続できません。

3. 「目的関数が空洞」のまま、対話だけが上手くなる

ここで多くのPoCが陥る罠があります。

AIが丁寧で親切な対話をするほど、満足度は上がります。しかし、製薬のエンゲージメントが本当に欲しいのは「会話の成立」ではなく、適正使用の促進、継続率改善、医療現場の負担軽減、情報格差の是正といった“成果”です。

LLMだけに任せると、目的が曖昧でも会話が成立してしまうため、改善が「プロンプト職人芸」になり、再現性が失われます。結果、投資判断もできなくなります。

4. データとルールの“現実”が後から追いかけてくる

顧客対応のテキストには、施設名、病状、個人情報が混ざります。ログの保存、匿名化、ベンダー責任分界、学習混入の防止——ここを曖昧にしたまま進むと、後から是正のコストが爆発します。

さらに、製薬は部署やチャネルごとに「言って良いこと/ダメなこと」が違います。LLMは境界を知らないので、統制の仕組みがないまま投入すると、最初は便利でも、最後に止まります。

結論:LLMは“文章担当”に置く。意思決定は別レイヤーに置く

AI Agentを使うなら、LLMを主役にしてはいけません。

LLMは対話のUIとして優秀ですが、正しさ・統制・監査性・目的最適化を担わせるのは危険です。

製薬で成立する設計はシンプルです。

- 根拠を固定する(社内一次情報のみ参照、参照元をログ化)

- 禁止領域をガードする(適応外示唆・比較表現・誇大などをルールで遮断)

- 高リスクを人へ戻す(AE、相互作用、適応外などは必ずエスカレーション)

- 目的を先に定義する(会話KPIではなく、適正使用や現場負担などKSF起点)

- 顧客の“タイプ”を前提に運用する(均一な対話ではなく、構造に合わせた介入)

ここで重要なのは、AI Agentの価値は「賢い会話」ではなく、「責任ある運用を成立させる構造」にあるという点です。

エンゲージメントとは、言葉を増やすことではなく、成果に向かう行動を増やすことです。LLMはその“最後の表現”には強い。しかし、表現だけで成果は生まれません。だからこそ、意思決定と統制の層を設計できる企業だけが、AI Agentを競争力に変えることが出来ます。