estimandのセミナーに参加しました。参加者から質問が出るたびに、解答には新しい情報やスキルが追加され、話がどんどん難解に、そして深く潜り込んでいく、そんな感覚を覚えました。限界や課題の話で終わるのではなく、あらゆる疑問に対してさらに高度な解答が返ってくる。その結果理解が追いつかない・・・。

では、estimandは「破綻のない完璧な理論」なのでしょうか。

答えは、完璧ではありません。ただし、完璧に“見えやすい”仕組みを持っています。estimandは「完璧だから難しい」というより、「破綻しないように設計されている」ために、質問を受けるたびに前提(定義・仮定・適用範囲)を追加していく構造になっています。だから解答が毎回“深く潜る”方向に伸びるのです。

estimandは「解析手法」ではなく「問いの仕様書」

estimandは、解析テクニックそのものではありません。むしろ“問いの仕様書”です。

質問が飛ぶということは、仕様書の曖昧さが露呈している、ということでもあります。

- どの効果を言いたいのか(治療方針込みか/仮想世界か)

- どのICEをどう扱うのか(中断、救済治療、併用薬など)

- 何を母集団とするのか(誰に一般化するのか)

- 何が観測され、何が欠測か(欠測メカニズム)

- どこまでが識別可能で、どこからが仮定か

こうした論点を、質問のたびに「仕様追加」していく。質問が鋭いほど、仕様追加は増えます。

「完璧に見える」のは、整合性を守るために条件が増えるから

estimandは議論が破綻しないように、言葉を定義し、対象を限定し、仮定を明示し、主張の射程を狭めることで整合性を保ちます。

だから“完璧”というより、整合性を守るために条件が増え続ける。これが難解さの正体です。

そして、ここが重要です。estimandには「限界」と「課題」があります。

- 未測定交絡を消すことはできない

- 欠測を魔法のように埋めることはしない(結局は仮定の問題)

- DAGや臨床知識の主観を排除できない

- 1つの正解を与えるというより、問いを複数に分解する

- 現場の複雑さを減らすというより、整理する枠組みである

つまりestimandは、「何でも答える理論」ではなく、答えられないものを“答えられない”と明示する理論です。

正しさが増えるほど、運用が死ぬ

問題は、ここまでを“正しく”やろうとすると、現場の負担が一気に跳ね上がることです。研究離れが進む状況で、「議論が破綻しない」ための枠組みが、逆に「研究が進まない」原因になってしまう──この逆説は起こり得ます。

そこで必要なのは、「理論をさらに深掘ること」ではなく、運用を破綻させないための工夫です。

現場に優しい落としどころとしては、まずは次の割り切りが効きます。

「正しい理解」を目指すより、運用として

- まず“3択だけ決める”(現実込み/仮想世界/忍容性込み)

- Primaryは1つ、Secondaryは少数(2〜3)

- それ以上は感度分析の領域として、答えを1本に固定しない

これだけで、“深掘り無限ループ”から抜けやすくなります。

estimandの限界を、DSAはどう補うのか

ここからが本題です。DSAができる補填は、estimandの穴を埋めて万能にすることではありません。そうではなく、estimandが要求する前提(特にICE/欠測/異質性)で破綻しやすい部分を、データ側から“構造化”して運用可能にすることです。

1) ICE(中断・救済治療・併用薬)で議論が終わらない問題

ICEの扱いを決めるほど現実が複雑になり、議論が終わらない。ここに対してDSAは、ICEを「例外」ではなく観測されたイベントとして分布構造に保持し、誰が・いつ・どんな条件でICEを起こすかを構造で提示します。

要するに、ICEを「仕様書の文章」から「構造の図・パターン」に落とし、会話を前に進める役割です。

2) 欠測(無回答・途中離脱)で仮定が積み上がる問題

欠測補完は仮定が増え、“リアルワールド”から離れやすい。DSAはまず欠測を埋めずに、欠測そのもの(無回答/離脱)を解析対象化し、欠測がランダムでない構造(どの層で欠測が増えるか)を可視化します。

補完が必要なら、その後に「仮定が効く場所」を明確化して感度分析の設計に繋げる。いきなり仮定に突っ込まない、という順番が重要です。

3) 異質性(効く人・効かない人、AEが出る人)が平均値に潰される問題

平均効果は仕様として綺麗でも、現場が欲しい“層の違い”は見えない。DSAは平均ではなく分布構造で効果の多様性を示し、AE中断層/非中断層など現実に意味のある層を「除外せず」に扱い、「どの層で勝ち、どの層で負けるか」を説明可能にします。

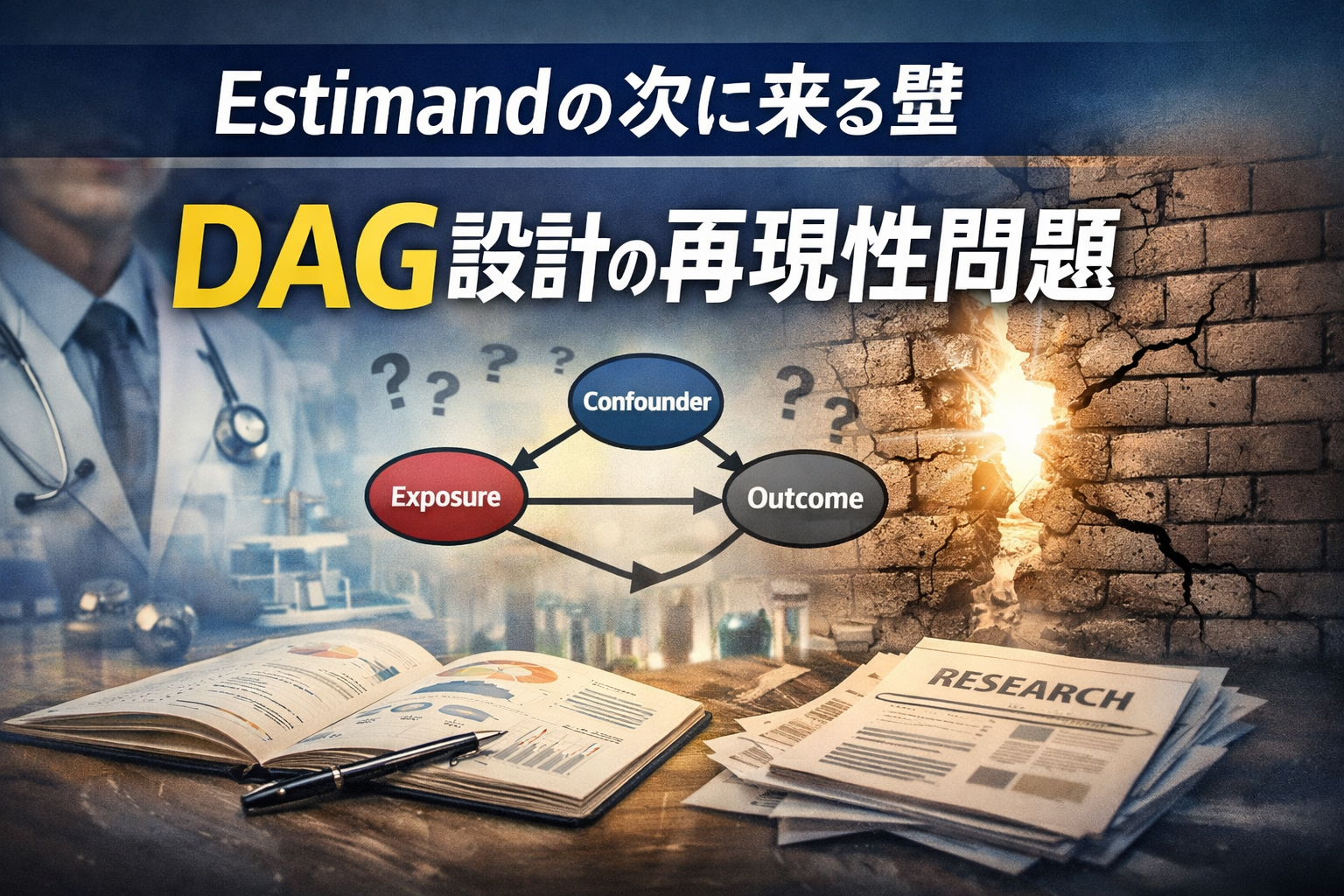

4) DAG固定の主観(暗黙知)問題

DAGを固定しても主観は残る。DSAはDAGを自動生成して正解を保証するものではありませんが、DAGの取り方で結論が変わるときに、データ構造側から「このDAGだと無理筋では?」を示す材料になります。主観をゼロにするのではなく、主観のリスクを監査可能にする、という位置づけです。

5) “本当の想定外”が起きる問題

リアルワールドでは本当の想定外が起きます。DSAはそれを予言しません。ただし、分布構造の変化点を捉えやすく、「いつから別世界か」「どの層が変わったか」を切り分けて、主張の適用範囲を守ることに貢献します。

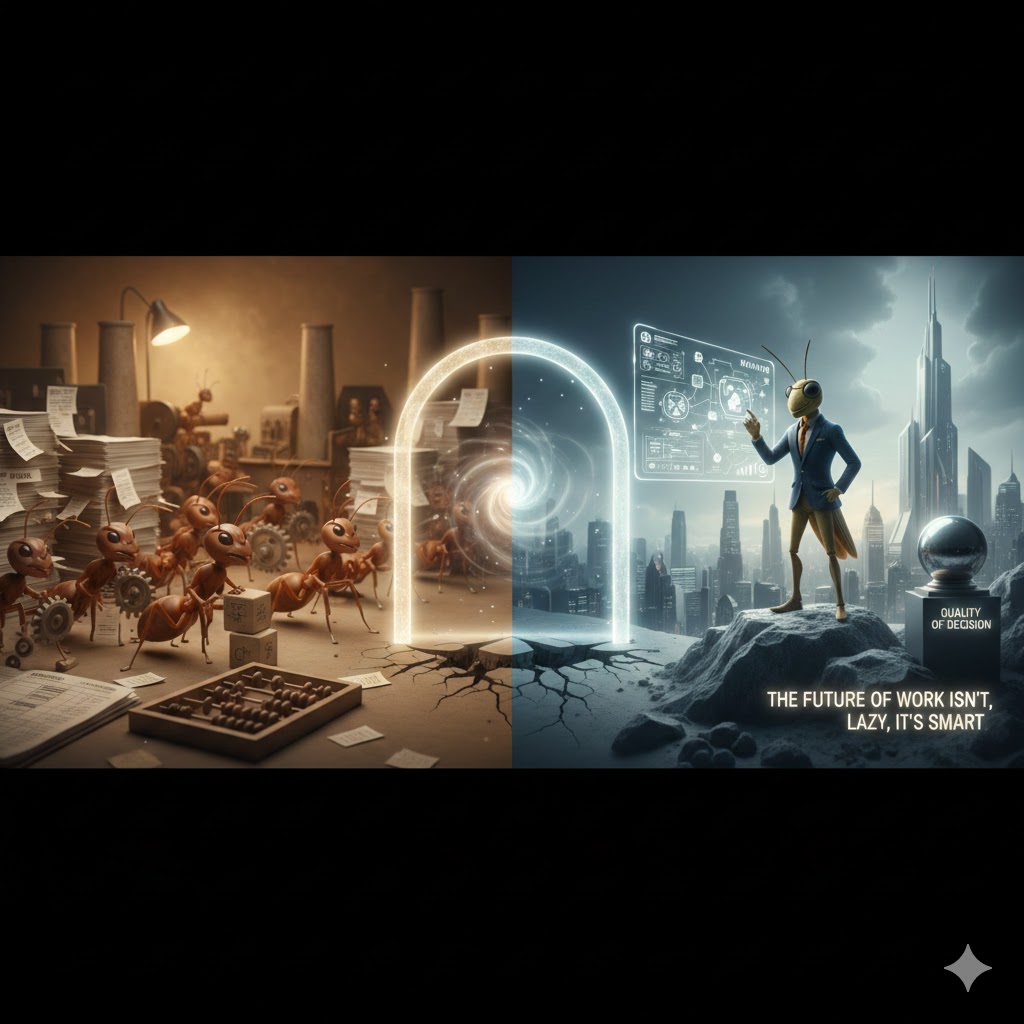

DSAは「難しいことを増やさず、破綻しにくい運用に寄せる」

estimandは、議論が破綻しないように条件が増える枠組みです。だからこそ、現場では運用が苦しくなります。

DSAは、estimandの限界(情報がない・現実が複雑)を消すのではなく、ICE/欠測/異質性/変化を構造として扱うことで、仮定の積み上げや恣意的除外に頼らず、現場で破綻しない運用へ落とすための補助線になります。

「完璧な理論」を追いかけて深く潜るよりも、現場が前に進むために、難しいことを“増やさないまま”正当性を守る。DSAが提供できる価値は、そこにあると感じています。