高市内閣が高い支持率を背景に解散総選挙に踏み切りました。この判断は吉と出るのか、凶と出るのでしょうか。政治の世界では暗黙知や経験則が語られがちですが、ここではあえて「因果モデルで占う」という前提に立ちます。支持率がとか野党がとか2値で語られることが多いですが、分析の鍵は、支持率という“平均値”をそのまま信じないことです。

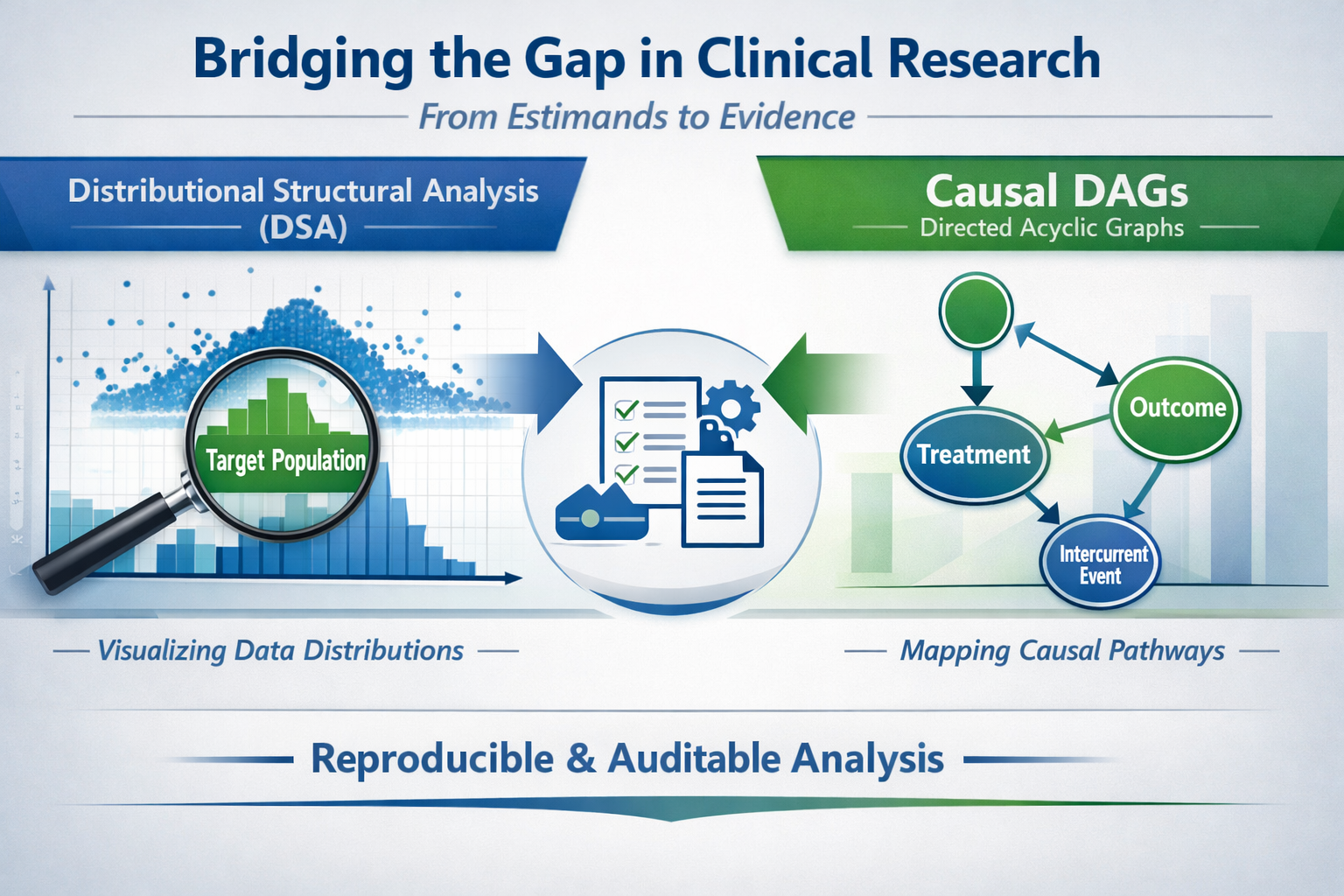

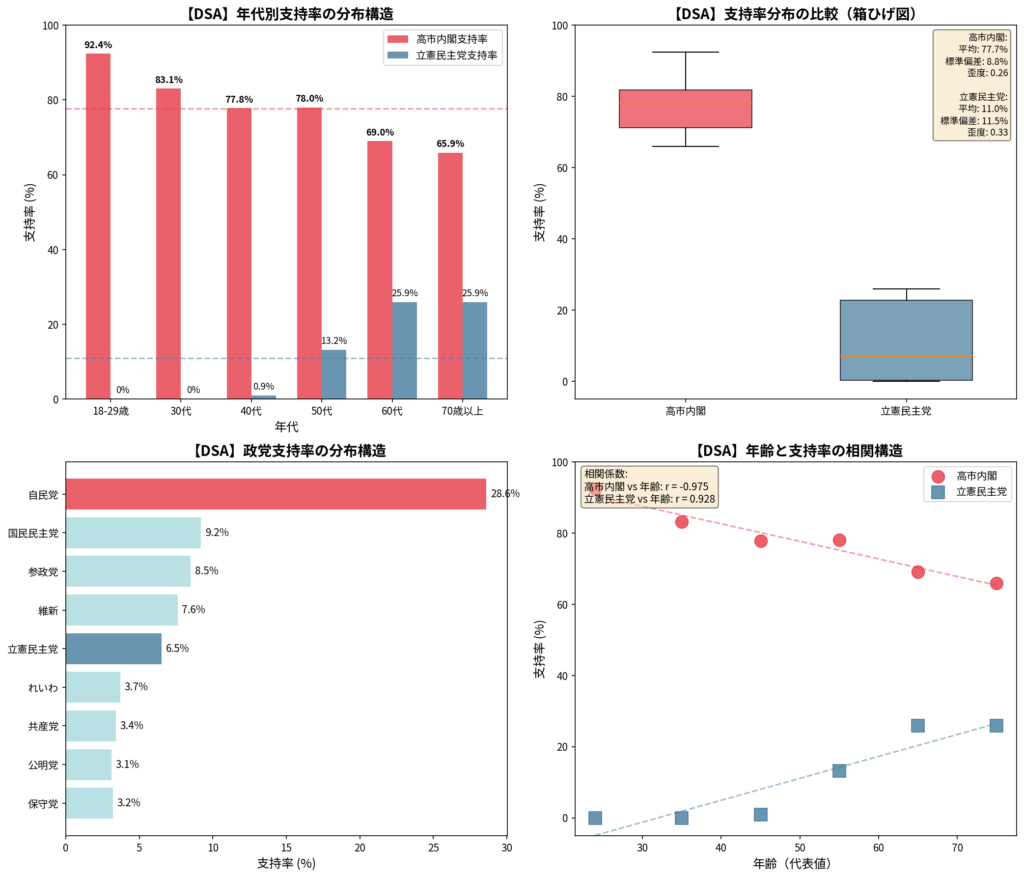

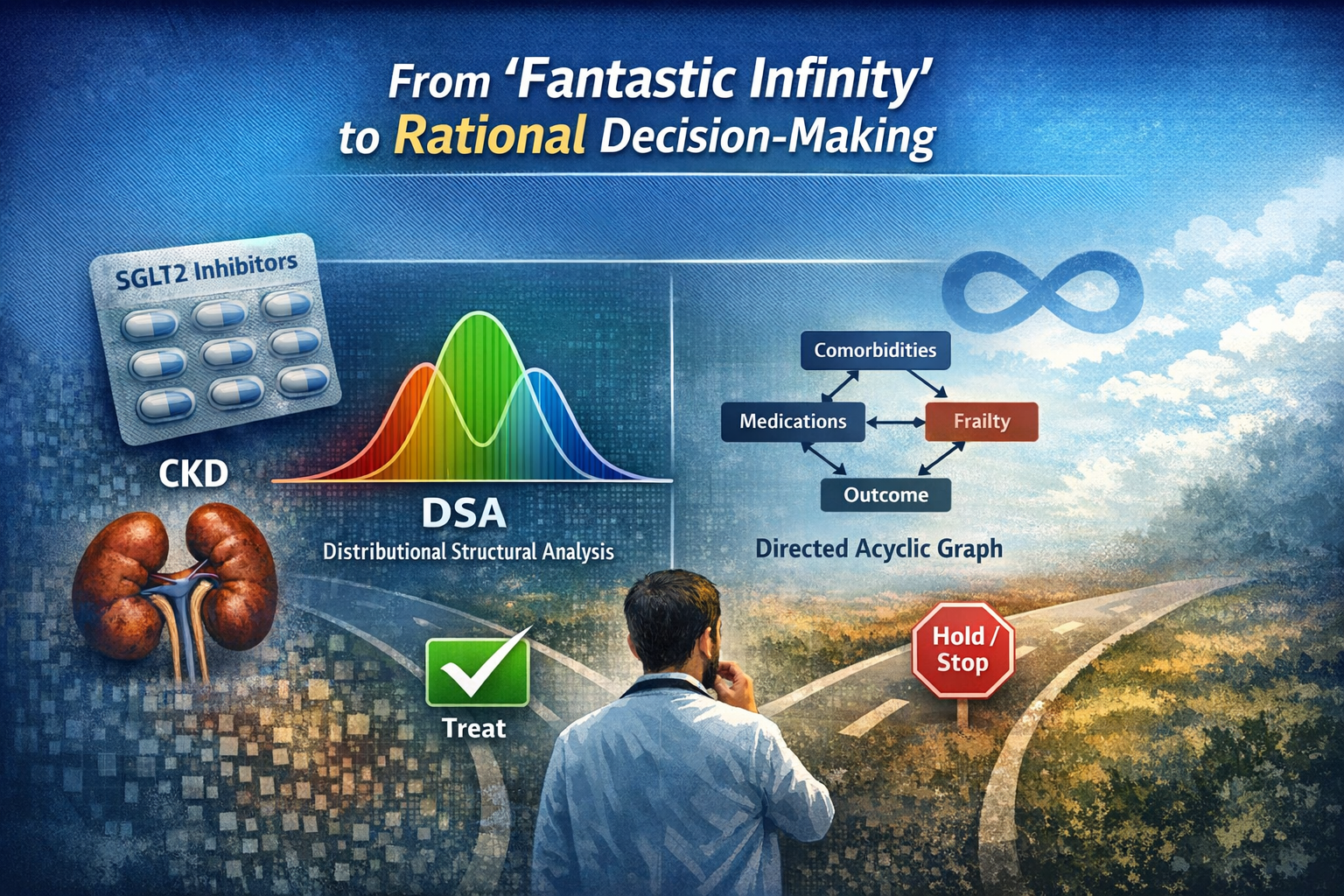

小選挙区制では、全国支持率の高さは勝利の十分条件ではありません。勝敗を分けるのは、接戦区に票がどれだけ集中するか、無党派がどの条件で動くか、そして投票率がどの層で上がるか。DSA(分布構造分析)は、支持や得票の分布を尖り・裾・多峰性として可視化し、支持が「薄く広く」なのか「勝てる帯域に厚い」のかを見極めます。支持率が高くても、分布の裾が安全区に偏れば議席には変換されません。

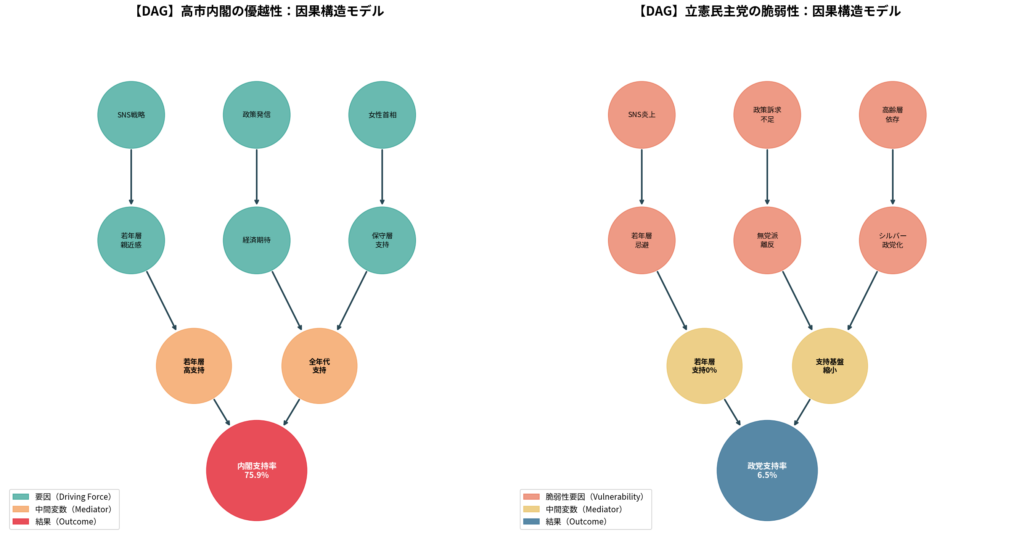

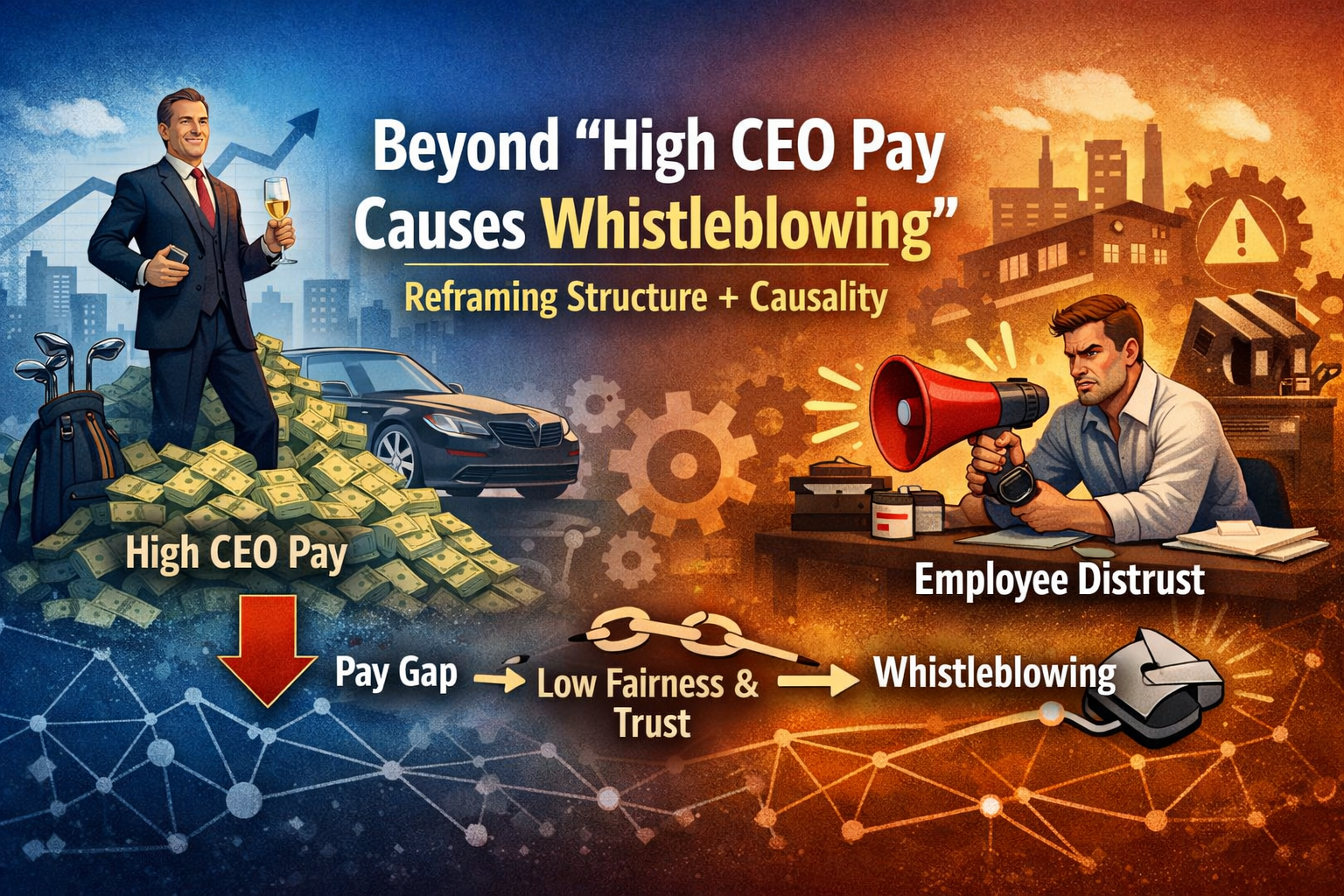

一方、DAG(因果グラフ)は“見かけの因果”を剥がします。年齢別支持の背後には、投票率、都市・地方の居住、所得や雇用、情報接触、争点の当事者性といった交絡が横たわる。解散のタイミングも同様です。経済指標や外交イベント、政策発表、メディア露出が同時に動く中で、「解散そのもの」の効果を他のショックと混同しない設計が不可欠になります。

DSA+DAGで占うと、問いはこう変わります。支持率は“どの分布”で、どの選挙区の接戦帯を厚くしているのか。動く無党派は、どの条件が揃ったときに投票に転ぶのか。解散は、その条件を強める介入になっているのか――それとも外部要因に埋もれるのか。吉凶の分かれ目は、支持率の高さではなく、因果の通り道が「議席」に向いているかどうかにあります。平均から分布へ、印象から構造へ。因果モデルは、解散判断の“勝ち筋”と“落とし穴”を同時に照らします。

1) 目的とEstimand(占う対象)を固定します

まず「吉凶」を1行で定義します。

- 主要アウトカム

:与党(または内閣支持基盤)の議席数(小選挙区・比例別でも可)

- 介入

:解散の実施(+タイミング:例「今月解散」 vs 「半年後」)

- Estimand(因果効果):

=「解散を選んだ世界」と「解散しなかった世界」の議席差

ここが揃うと、評論は「好き嫌い」ではなく「効果の推定」に変わります。

2) DAGテンプレ(ノード設計)

最低限、次のノード群を置きます(括弧は代表的な観測変数例)。

介入と結果

:解散(実施・タイミング)

:選挙結果(議席、得票率、勝敗)

主要な因果経路(媒介:M)

解散が結果に効くなら、途中で何かが動きます。

:投票率(全体・年齢別・地域別)

:無党派の投票先分配(浮動層のスイング)

:争点サリエンス(何が主要争点になるか)

:候補者・選挙区力学(候補者調整、接戦区の集中)

交絡(C:TにもYにも効く“混ざり物”)

ここを塞がないと、相関を因果と誤認します。

:政権状態(内閣支持・不支持、党支持、スキャンダル)

:マクロ環境(物価・賃金・景気、国際情勢、災害など外生ショック)

:選挙区構造(都市/地方、過去の得票分布、接戦度、人口動態)

:対抗側の状態(野党の候補者調整・分裂、連立の枠組み)

:調査・情報環境(メディア露出、SNS話題、世論調査モード差)

基本DAG(文字で表す骨格)

(支持率や経済が“解散判断”に影響)

(同じ要因が“選挙結果”にも影響)

(解散が投票率や無党派を動かし議席へ)

3) 調整セット(何をコントロールし、何をしないか)

ここが「相関→因果」を決める核心です。

まずやる:バックドアを塞ぐ(推奨の調整)

- 調整する(C):

内閣/党支持のトレンド、経済指標、外生イベント、選挙区構造、対抗側の状態、情報環境(最低限 proxy でも) - 調整しない(M:媒介):

投票率や無党派スイングは、解散の効果そのものの通り道なので、基本は調整しません(やるなら別Estimand=「直接効果」にします)。

これで「支持率が高いから勝つ」という相関の短絡を避けられます。

「支持率が高い“から”解散し、同時に勝ちやすかっただけ」という混同(交絡)を潰します。

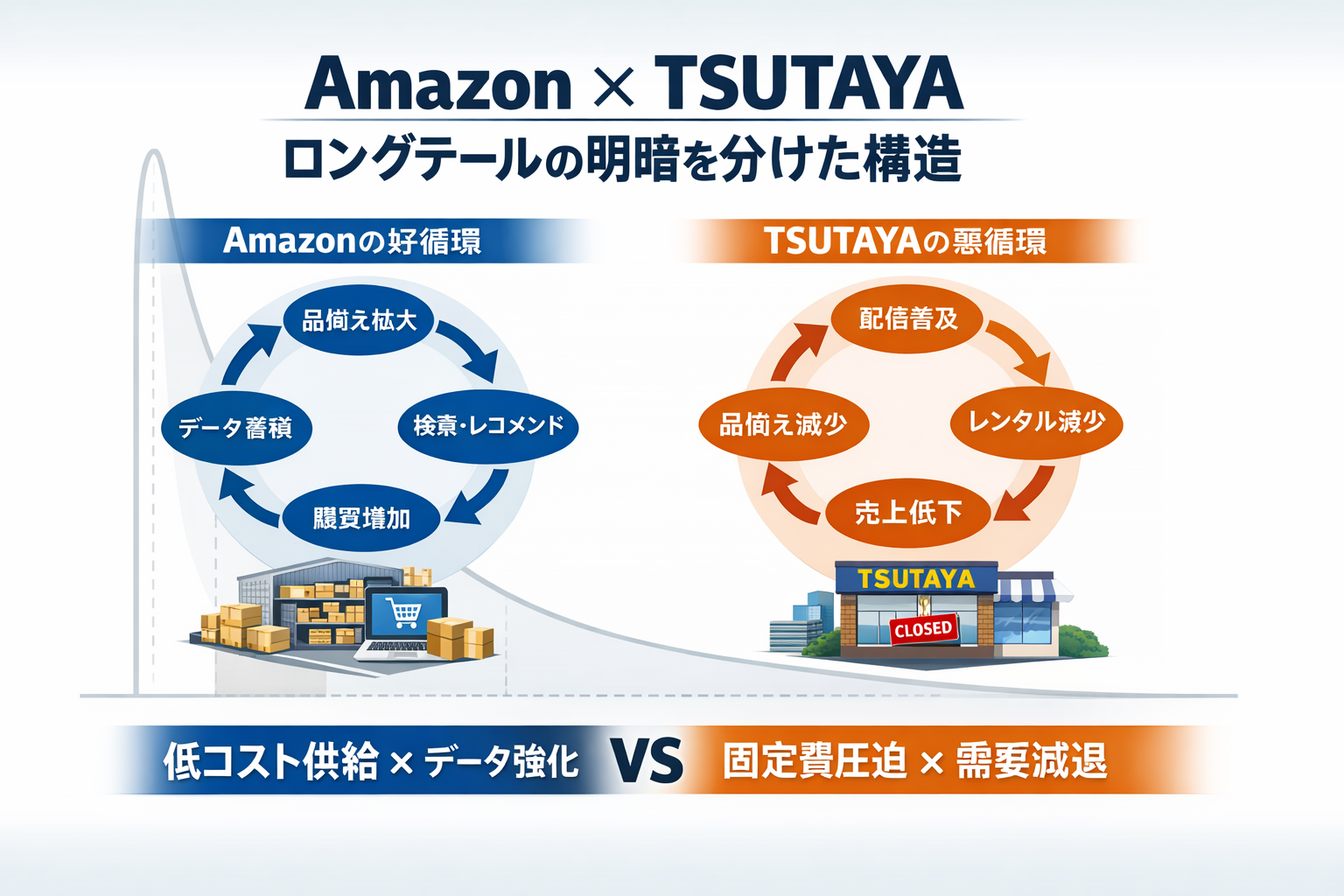

4) DSA設計(“平均の支持率”を分布に分解して勝敗変換を点検)

DAGで構造を固定した上で、DSAで「議席に変換される形か?」を見ます。

可視化①:選挙区別の“接戦帯”分布

- 指標:与党(または主要党)の選挙区得票率分布

- 見る形:45–55%帯の厚み、裾の伸び、尖り

- 解釈(占いのルール)

- 接戦帯が厚い:小さな揺れで議席が大きく動く → 吉凶の振れ幅が大

- 安全区に尖る:票が積み上がっても議席は増えにくい → 凶寄り(変換効率が悪い)

可視化②:地域偏在(山がどこに立つか)

- 都市/地方、ブロック別に分布を並べる

- 解釈:支持が「増える場所」と「議席が増える場所」が一致しているか

可視化③:無党派の“分布分解”

- 「支持なし」を1つにせず、

常時無党派 vs 浮動無党派(直前変動しやすい層)

を分ける(代理変数でもOK) - 解釈:解散が動かすのはどちらか(動く層が多いほど“解散の効果”は出やすい)

可視化④:年齢別支持×投票率(ここで“見かけの年齢効果”を剥がす)

- 年齢別「支持」だけでなく、投票率で重み付けした分布を見る

- 解釈:若年支持が強くても投票に変換されなければ議席影響は小さい

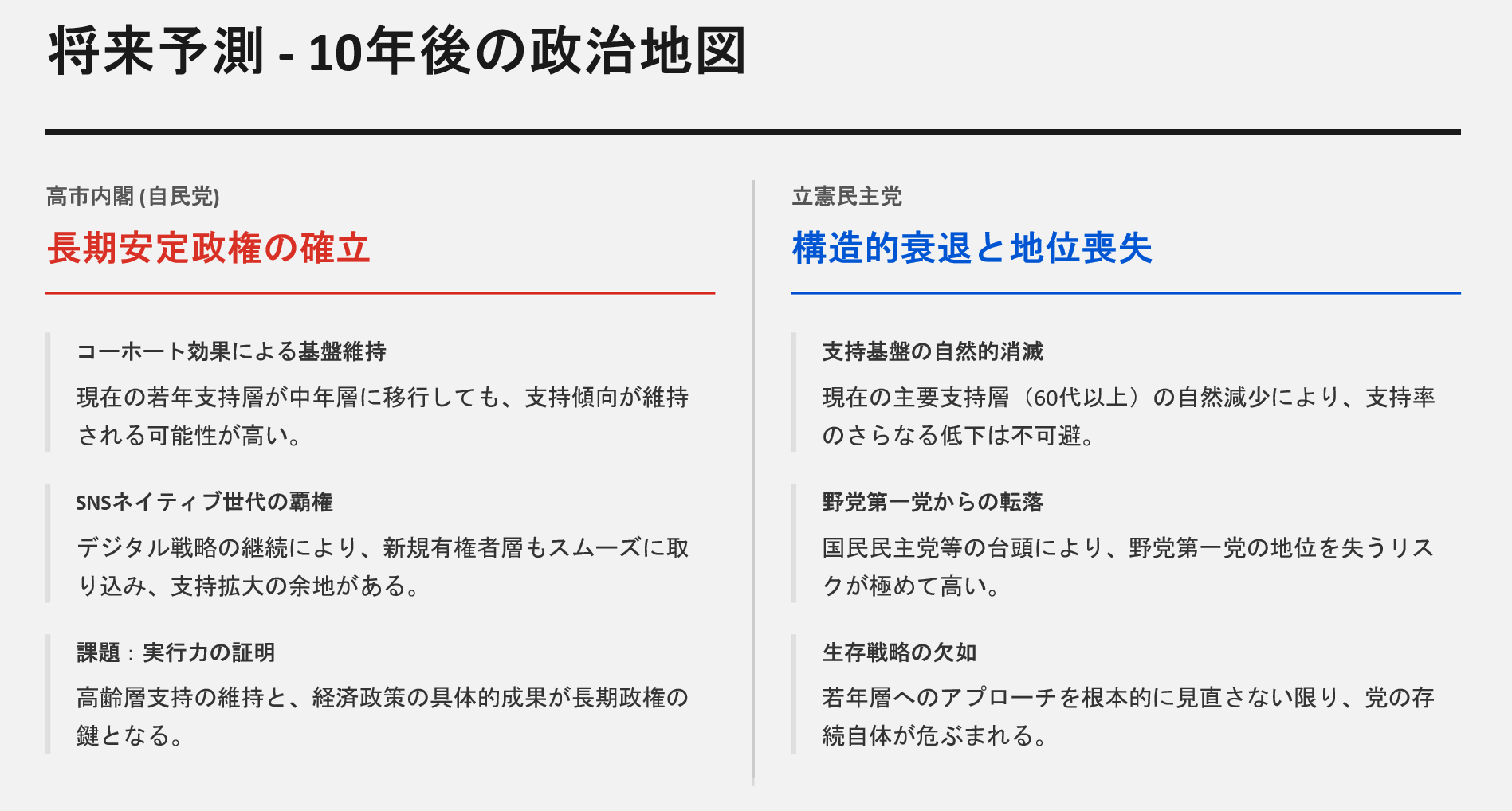

5) 「吉と出る/凶と出る」を因果モデルで言い換えると

主観の代わりに、次の2条件で結論を出します。

- 条件A(DAG):交絡を塞いだ後も、

の道が太い

(解散が投票率・無党派・争点を動かす見込みがある) - 条件B(DSA):その動きが 接戦帯 と 議席増加が起きる地域に集中している

AもBも満たす → 吉

AはあるがBがない(安全区に偏る等)→ 凶

Aが弱い(解散しても何も動かない)→ 凶

Aは強いが不確実(接戦帯が極厚で多峰性)→ ハイリスク・ハイリターン