「みんなが選んでいるから変動金利で大丈夫だろう」――そんな風に考えてはいませんか? 住宅ローンの借入限度額が1億5,000万円まで引き上げられるなど、私たちが背負うリスクの総量はかつてないほど大きくなっています 。人生最大の買い物において、今求められているのは「なんとなく」の予想ではなく、論理的な納得感です 。

今回は、最新の意思決定手法である「DSA(分布構造分析)」と「DAG(有向非巡回グラフ)」の視点から、金利選びにおける「相関」と「因果」の違いを紐解きます。

*ミュートしています

1. 「相関」で選ぶリスク:バックミラーを見て運転していませんか?

多くの人が参考にする過去の金利チャートは、いわば「相関ベース」の分析です 。 「過去30年間、日本の金利は上がらなかった。だから明日も上がらないはずだ」という考え方は、過去のパターンが未来も繰り返されることを前提としています 。

しかし、これは**「バックミラーだけを見て、カーブの多い道を運転する」**ようなものです 。過去30年の日本はデフレという特殊な環境にありました 。環境そのものが変わる「構造変化(レジームチェンジ)」が起きた瞬間、過去のデータに基づいた予測は全く役に立たなくなってしまいます 。

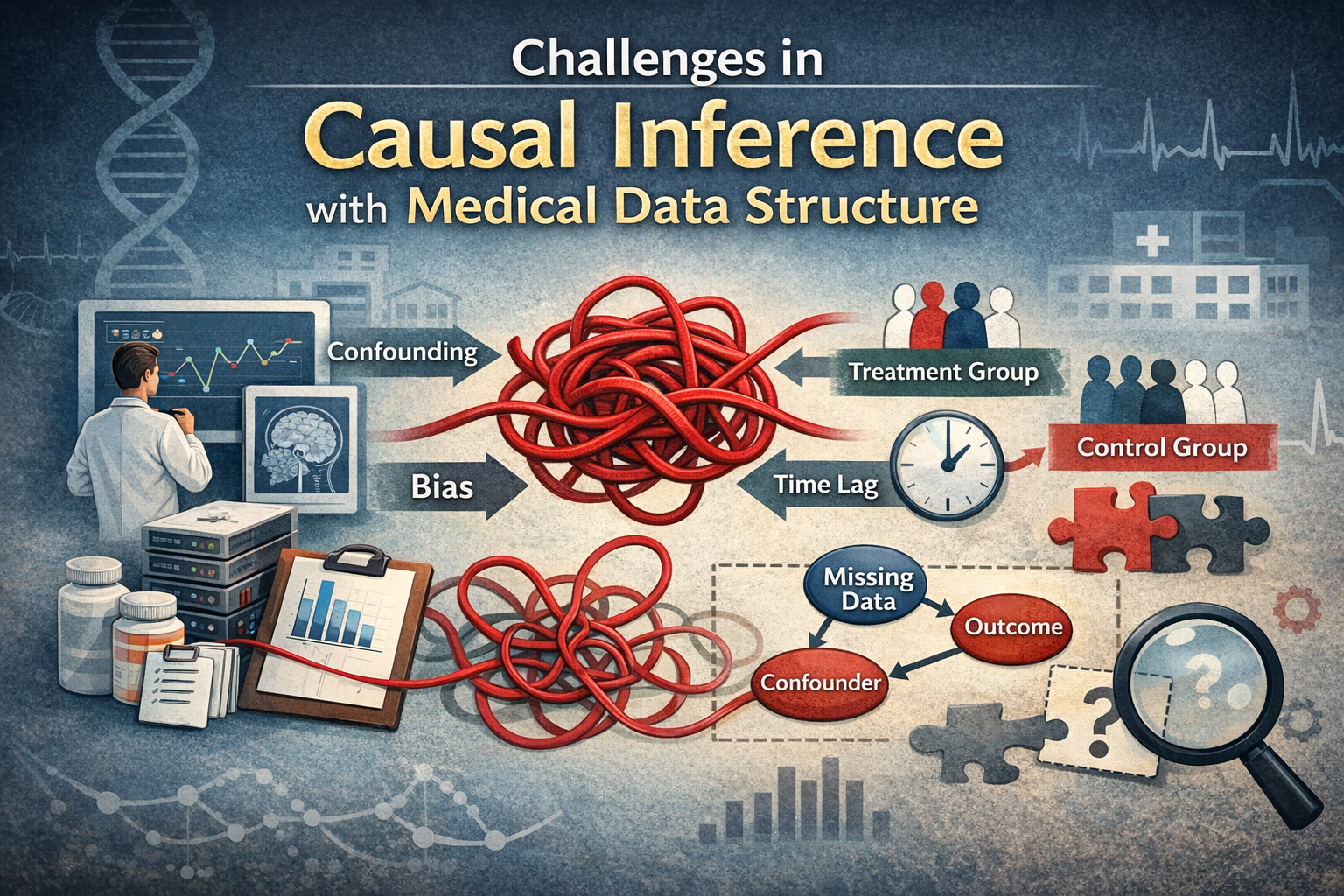

2. 「因果」で選ぶ知恵:チャートを動かす「メカニズム」を知る

一方で、最新の「因果ベース(DSA+DAG)」の分析は、チャートの形ではなく、「なぜ金利が動くのか?」というメカニズムに注目します 。

例えば、金利上昇の裏側には以下のような「因果の連鎖(DAG)」が隠れています。

- 海外要因: 米国の金利上昇 → 円安 → 輸入物価の上昇 → 国内インフレ → 日銀の利上げ

- 国内要因: 人手不足 → 賃金の上昇 → サービス価格の上昇 → 日銀の利上げ

「金利が上がるか」という漠然とした不安を、こうした具体的なステップに分解することで、ブラックボックスを解消できるのです 。

3. 「マグマの蓄積」をデータで捉える

さらに「DSA」という手法を使えば、現在の経済状況が過去のデフレ期とどれだけ異なっているかを数値化できます 。 表面的な金利がまだ低くても、背後にある物価や賃金のデータの広がり(分布)が過去と大きくズレていれば、それは**「金利急騰のマグマ」**が溜まっているサインです 。

あるシミュレーションでは、賃上げ率が3%を超え続けた場合、5年以内に変動金利が固定金利(2.6%)を追い越す確率は65%という結果も出ています 。

結論:納得感のある決断を

「みんなが変動金利だから」という同調バイアスで選ぶのではなく、「インフレ構造への転換に備える」という明確な意志を持って選ぶこと 。 DSA+DAG分析は、不確実な時代において、あなたの人生を守る「科学的な羅針盤」となります 。