これまで、とりあえずなんでもかんでもデータを取っておけば、あとで分析すれば「なにか予期せぬ面白い発見があるかも」と思っても、現実には、あとから解析してみても「期待は不発」で終わる。これ、けっこうよく聞く話です。

この「期待は不発」でおわる問題は、データ不足というより、後から解析する側が置いている前提に起因しています。典型的には次の3つです。

1) 解析は「平均の世界」に引っ張られる

多くの解析は、まず平均(差)や線形関係を見にいきます。

平均は全体を一言で言える反面、現実に多い「混ざりもの」を消します。

- 効く人と効かない人が混在している(二峰性)

- 少数の強い反応者が全体を支配している(ロングテール)

- ある条件を境に挙動が変わる(閾値)

こういう構造は、平均を取った瞬間に無効化します。つまり、面白いはずの“差”が、解析の入口で既に平坦化される。これが「何も出ない」の第一原因です。

2) 「問い」がないまま解析すると、出てくるのは“説明しやすいもの”だけ

とりあえず集めたデータは、裏を返すと「何を見るか」が固定されていません。

この状態で後から解析すると、人はどうしても

- 手元にある変数で説明できる

- 絵にしやすい

- 既存の枠に当てはめやすい

方向へ寄ります。結果として、出てくるのは「想定内」「教科書的」「既視感のある結論」になりがちです。

発見がないのではなく、発見の入口が“都合の良い説明”に偏るということです。

3) 現実データは「原因と結果」が最初から混ざっている(交絡・選択・介入の歪み)

特にRWDでは、データは自然発生的に集まるので、純粋な比較になりません。

- そもそも治療や介入が“選ばれている”(重症度や医師判断など)

- 測定の頻度自体が状態に依存する

- 欠測がランダムではない

- フォローアップが均一ではない

この状態で単純に相関を見ると、「関係がある/ない」が揺れます。

そして解析者は、揺れを収束させるために

方向へ進みますが、ここで“本来の構造”がさらに見えにくくなることがあります。

つまり、RWDの世界では、解析の難しさがデータの中に埋め込まれている。これが「後からやっても成果が出ない」第二原因です。

とりあえず集めたデータが、あとから“問いを生む”状態を作る

そして、その問いが“検証できる形”で残るようにする

ということです。

「集めたのに何も出ない」という経験の無力感は、

時間やコストが無駄になること以上に、次に何をすればいいかが残らないことです。

「DSA+DAG」は、この“次が残らない”を変えにいきます。

たとえば、プロダクトで新機能を追加したとします。

「継続率が上がるはず」「CVが上がるはず」と期待して、ログも一通り取った。

ところが1か月後に分析すると、結果はこうです。

- 全体のCV:ほぼ変わらない

- 継続率:微増だけど誤差っぽい

- 平均滞在時間:むしろ少し下がった

で、会議の結論がだいたいこれになります。

「効果は限定的でした」「次の施策を考えましょう」

ここで“あるある”なのは、平均で見る限り、何も起きていないように見えることです。

でも現場の感覚としては、「刺さった人は明らかに喜んでいる」という手応えがある。なのに数字に出ない。

このとき起きているのは、だいたい次のどれかです。

- 効いた層と効かなかった層が混ざって平均で相殺されている

- 少数のヘビーユーザーだけが強く反応して、全体平均には出ない(ロングテール)

- そもそも機能を“使った人”が偏っている(選択バイアス)

- 「使った→良くなった」ではなく「元から熱量が高い人が使った」だけ(逆因果っぽい)

つまり、“何も出ない”のではなく、

何かが起きているのに、平均のレンズだとそれが見えない。

同様に、RWDからRWE構築のメッセージを雑に要約すると、

- RWDをとにかく集めろ(蓄積を進めろ)

- RWEにしろ(意思決定に使える形にしろ)

- しかも因果で説明できるようにしろ

- その方法は各自で考えろ(考えろと言う)

となっていて、「とりあえずデータだけ取っておけば、あとで分析して面白い発見があるかも」と趣がほぼ同型です。

違いがあるとすれば、国の要求はさらに一段きつくて、

「何か見つけろ」ではなく 「因果で説明しろ」まで要求している点です。

つまり、単なる“発見”ではなく、意思決定に耐える説明責任を求めていることです。

だから現場では、

- データは溜まる

- でも「切り取り前提」の解析では因果が立ちにくい

- 結果、「RWDはあるがRWEにならない」が起きる

という“あるあるループ”が、構造的に再生産されやすくなるのです。

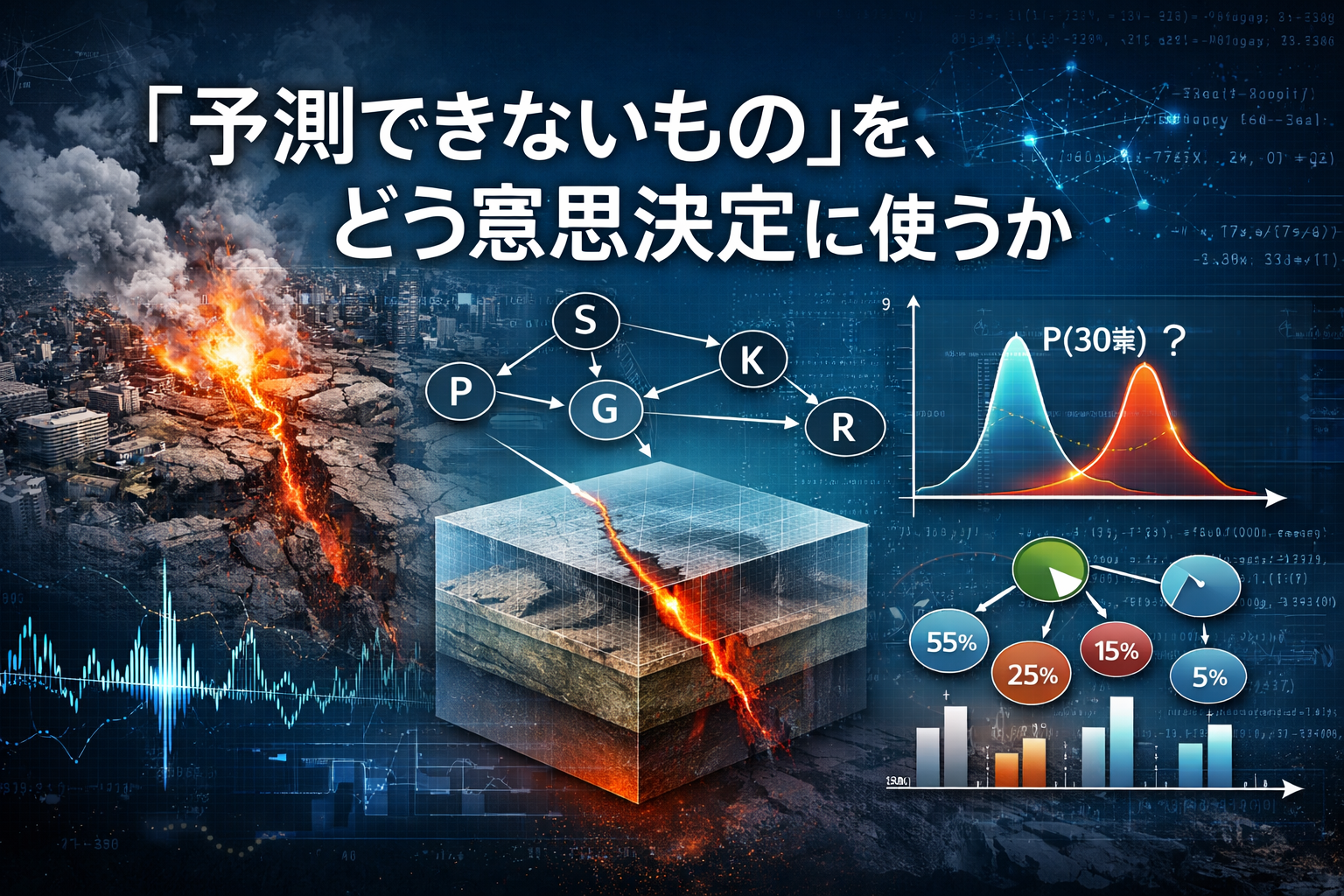

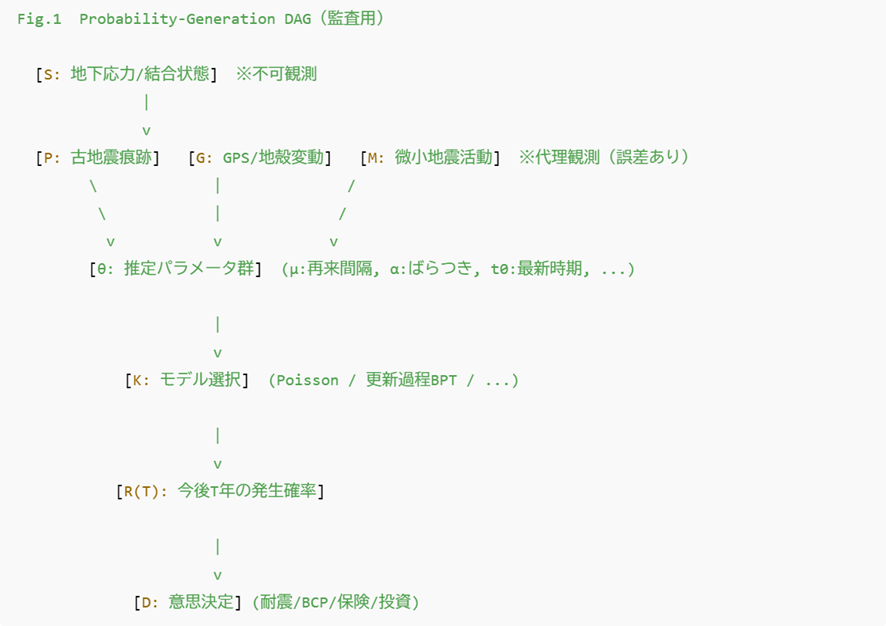

では、どうするか?

RWDを集めるだけではRWEにならない。

RWEにするには、RWDを切り取る前に“あるがまま”の構造を捉え、因果として説明できる形に落とす道具立てが必要。

その解決策として、DSA+DAGを置くと、単なる解析手法ではなく、要求に応えることが出来る「現実的な解法」となります。

- DSAは、まず「全体平均」ではなく、分布が割れていないかを見る

(一部が大きく改善して、別の一部が悪化していないか、少数の尖りがないか)

- そしてDAGで、「誰がその機能を使う(選ぶ)のか」という偏りを含めて、

“効いた”のか“選ばれただけ”なのかを切り分ける問いにする

これができると、結論が「効果なし」で終わりません。

「効く人の条件はこれ」「効かない人はここが詰まっている」

「次の打ち手はプロダクト改善か、導線か、対象の切り替えか」

と、“次の一手が残る”形になります。

これまでのRWD活用は、どこかで「必要なデータだけ切り取って、仮説を検証する」前提になりがちでした。もちろん合理的です。ただ、そのやり方だと、RWDの一番大事な特徴、“現実の混ざり方、偏り方、ばらつき方”というリアルが、解析の入口でそぎ落とされてしまいます。結果として、あとから解析しても「平均的にはこうです」という話に寄り、現場が本当に知りたい「誰に、なぜ、どう効くのか」が残らない。これが“RWDがRWEになりきらない”典型パターンです。

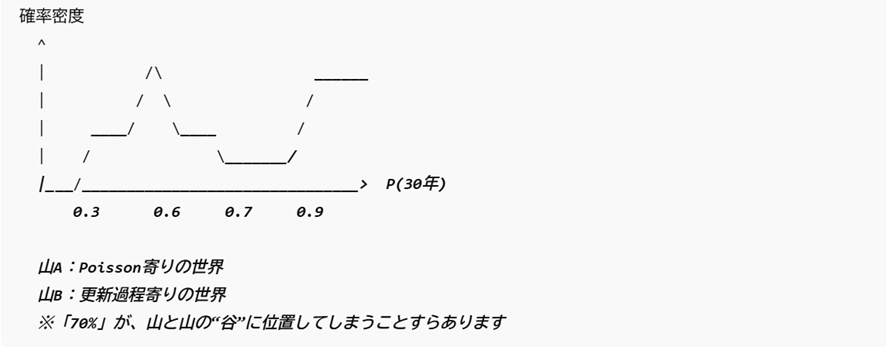

DSA+DAGが狙うのは、その逆です。RWDを「切り取る」より先に、まずあるがままの分布構造として見る。割れ(効く群/効かない群)、ロングテール(少数が全体を動かす)、閾値(境目で挙動が変わる)、欠測や選択の偏りなど、こうした現実のクセを、ノイズとして消さずに情報として保持します。すると、RWDの中に埋まっていた「分岐」や「偏り」が表に出てきて、データの側から「問い」が立ち上がるようになります。

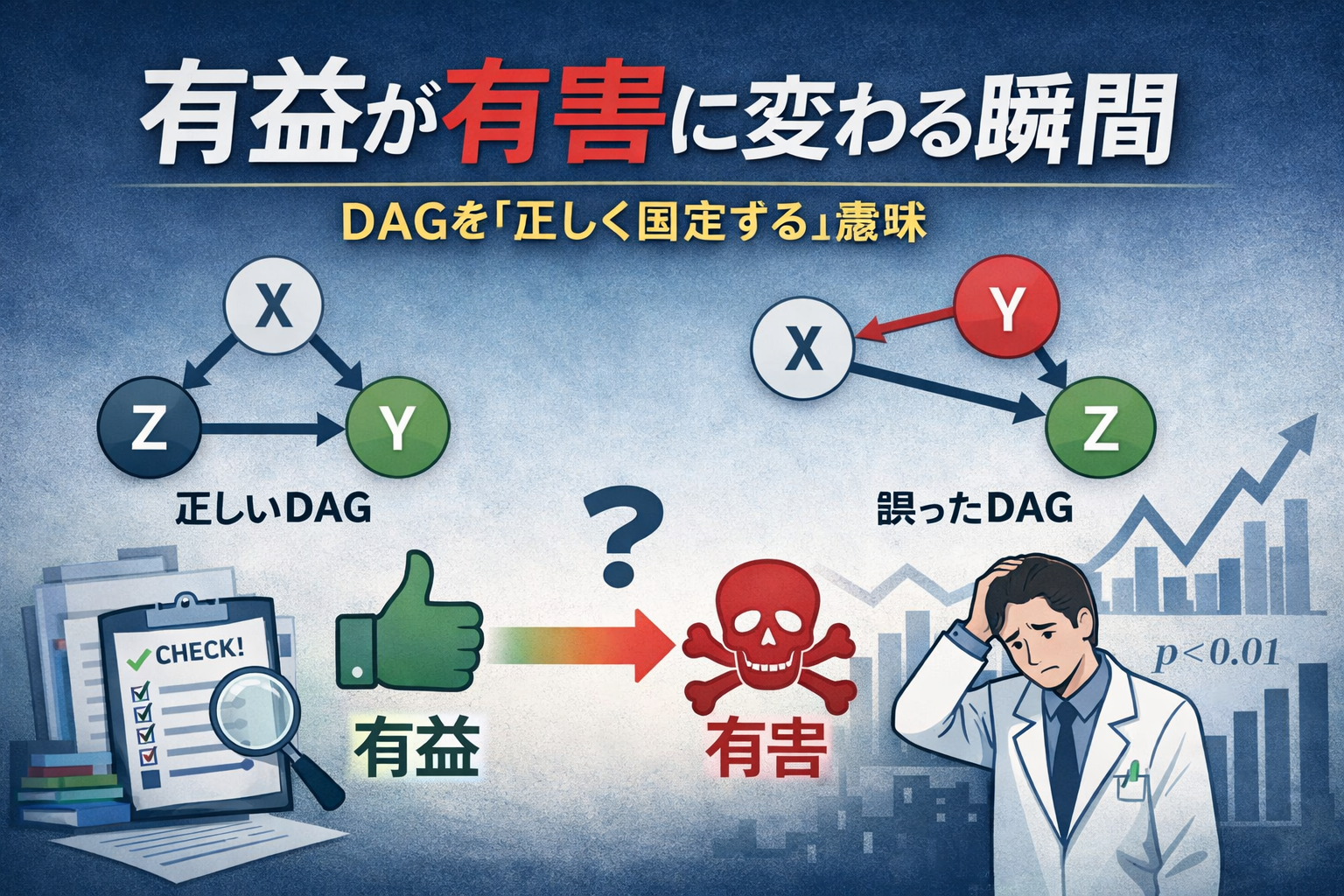

ただし、分布のクセが見えただけではRWEにはなりません。そこでDAGです。DAGは、その分岐や偏りを「因果の問い」に翻訳します。治療が選ばれた理由(選択バイアス)、重症度や背景因子の混入(交絡)、測定頻度や欠測が結果に与える影響など、それらを構造として整理し、「どこを調整し、何を介入とみなし、何をアウトカムと定義すべきか」を明確にします。ここまで落とすことで、RWDは“ただの相関の集まり”から、検証可能で意思決定に使える因果の証拠へと変わります。